Ausgabe 03/2025

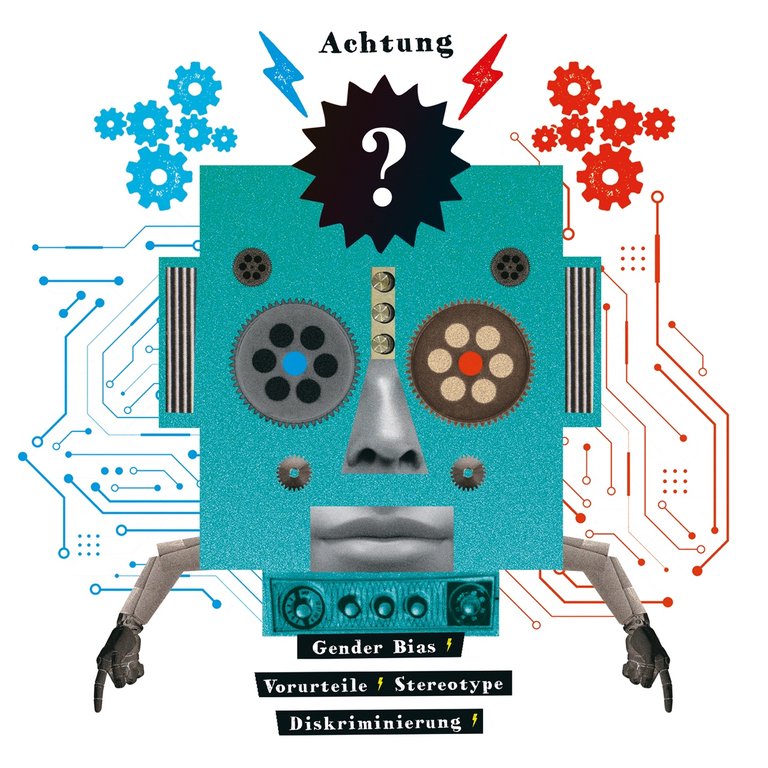

Gender Bias in der KI: Wie Künstliche Intelligenz Stereotype verstärkt – und was dagegen hilft

Beim Übersetzen mit einer KI ist Vorsicht geboten: Wird ein geschlechtsneutraler englischer Satz ins Deutsche übertragen, zeigt sich, wie schnell KI unbewusst in stereotype Denkmuster verfällt: "The nurse is preparing medication" wird fast immer zu "Die Krankenschwester bereitet Medikamente vor", während "The doctor is preparing medication" zuverlässig als "Der Arzt bereitet Medikamente vor" erscheint. Obwohl das Englische keine Geschlechtszuweisung trifft, ordnet die KI typische Berufe automatisch bestimmten Geschlechtern zu, weil die Daten, mit denen die KI trainiert wurde, vor allem Männer in diesen Rollen zeigen. So werden bestehende Rollenbilder durch die Technik verstärkt und systematische Verzerrungen entstehen – Gender Bias. Es ist kein Zufall, sondern das Ergebnis der Daten, mit denen diese Systeme trainiert werden.

Im Rahmen der ver.di-Veranstaltung KI und Gender – Chancengerechtigkeit versus Diskriminierungsgefahren erklärte Prof. Dr. Katharina Simbeck von der Hochschule für Technik und Wirtschaft Berlin: "KI-Systeme lernen aus großen Datenmengen und ziehen daraus Muster. Doch sie übernehmen nicht nur Zusammenhänge, sondern auch bestehende Vorurteile und Stereotype."

Gender Gap bei der Nutzung

Noch deutlicher zeigt sich dies bei der Bildgenerierung durch KI: Eine Anfrage nach einem "Engineering Professor" erzeugt ausschließlich Bilder von männlichen, meist weißen Akademikern. Fragt man nach einer oder einem Grundschullehrer*in, im englischen geschlechtsneutral "Primary school teacher", erscheinen fast ausschließlich junge Frauen.

Eine Ungleichheit der Geschlechter zeigt sich aber auch in der praktischen Nutzung der Anwendungen. Dr. Sandra Arndt, Geschäftsführerin der Initiative Chef:innensache e.V., präsentierte den Teilnehmenden der ver.di-Veranstaltung eine aktuelle Studie zur Nutzung von KI im Arbeitskontext: "Nur 32 Prozent der Frauen vertrauen KI, bei den Männern sind es 47 Prozent Auch bei der beruflichen Nutzung gibt es signifikante Unterschiede: 40 Prozent der Frauen setzen KI nicht ein, bei den Männern sind es nur 31 Prozent

Diese Diskrepanz setzt sich in der Selbsteinschätzung fort: Nur 30 Prozent der Frauen halten ihre KI-Kompetenzen für gut, während 43 Prozent der Männer dasselbe von sich behaupten. "Besonders problematisch ist, dass dieser Gender Gap über alle Altersgruppen hinweg bestehen bleibt", sagt Arndt.

Ein alarmierender Befund: Während KI zunehmend den Arbeitsmarkt und Entscheidungsprozesse durchdringt, bleiben Frauen in der Anwendung und Gestaltung der Technologie zurück. Hier sind gezielte Maßnahmen gefragt, um Chancengleichheit zu gewährleisten.

Klare Standards in Europa

Europa hat mit der KI-Verordnung eine der umfassendsten rechtlichen Grundlagen für den Umgang mit Künstlicher Intelligenz geschaffen. Ein zentraler Punkt ist Artikel 4 der Verordnung, der vorschreibt, dass alle Personen, die mit KI-Systemen arbeiten, über entsprechende Kompetenzen verfügen müssen. Dies soll sicherstellen, dass KI diskriminierungsfrei genutzt wird und dass Beschäftigte in Unternehmen KI-Systeme kritisch hinterfragen können.

Ein weiteres Element der Verordnung ist die Transparenzpflicht für Hochrisiko-KI-Systeme. Insbesondere bei Anwendungen, die in Personalentscheidungen, Bewerbungsverfahren oder im Finanzwesen eingesetzt werden, sollen klare Kriterien für die Nachvollziehbarkeit von Entscheidungen eingeführt werden. Diese Regelungen könnten dazu beitragen, dass KI nicht unreflektiert bestehende Vorurteile verstärkt, sondern gezielt überprüft und angepasst wird.

Doch während Europa klare Standards setzt, sieht es in anderen Regionen anders aus: In den USA gibt es bislang keine einheitliche KI-Regulierung, und viele Unternehmen setzen auf Selbstregulierung.

Normen werden reproduziert

Weltweit entwickeln nur wenige große Tech-Konzerne wie OpenAI, Google oder Meta die leistungsfähigsten Sprachmodelle. Ihre Entscheidungen prägen, welche Inhalte KI generiert – und welche nicht.

Ein Beispiel: In einer frühen Version von ChatGPT lautete ein automatisch erstellter Satzvorschlag: "The people getting married are Lisa and Mark, who met in college and have known each other for four years."

OpenAI bewertete diesen Vorschlag als zu einseitig, weil er ein heterosexuelles Paar als Standard darstellt. Um mehr Vielfalt zu ermöglichen, verzichtet das System in der finalen Version auf konkrete Namen – so bleibt die Geschichte offen für unterschiedliche Konstellationen.

Dieses Beispiel zeigt, wie stark ethische Entscheidungen in die Entwicklung einfließen – und wie KI dadurch auch gesellschaftliche Normen (re)produzieren kann.

Vielfalt notwendig

Katharina Simbeck von der Berliner Hochschule für Technik und Wirtschaft plädiert deshalb dafür, dass Unternehmen und Institutionen "Diversity Panels" einsetzen, um KI-Systeme auf diskriminierende Muster zu überprüfen. "Wir wissen, dass KI-Modelle fehlerhaft sein können. Eine Lösung könnte darin bestehen, ein Gremium aus verschiedenen Stakeholdern einzurichten, das KI-Systeme auf Diskriminierungseffekte untersucht. Unternehmen könnten eine solche Gruppe bereits in der Einführungsphase eines KI-Systems einbinden. Eine solche Panel-der-Vielfalt-Struktur könnte helfen, problematische Muster frühzeitig zu identifizieren und entgegenzuwirken."

Aus gewerkschaftlicher Sicht sind Betriebs- und Dienstvereinbarungen ein zentrales Mittel, um faire Bedingungen bei der Nutzung von KI zu schaffen, findet Dr. Nadine Müller, Leiterin des ver.di-Bereichs Innovation und Gute Arbeit: "Es gibt bereits verschiedene betriebliche Vereinbarungen und Leitlinien. Wir empfehlen weniger eine starre Mustervereinbarung, sondern vielmehr einen prozeduralen Ansatz, bei dem Beschäftigte von Anfang an in die Einführung von KI-Technologien eingebunden werden."

Außerdem müssten geschützte Räume angeboten werden, schlägt sie vor. "In reinen Frauengruppen könnten sich Teilnehmerinnen freier fühlen, um Fragen zu stellen, ohne sich unter Druck gesetzt zu fühlen." Dabei seien auch Gewerkschaften, Betriebs- und Personalräte gefragt, die Einfluss auf Qualifizierungsangebote nehmen können. "Auch wenn wir uns mehr Mitbestimmung wünschen, haben wir bereits Möglichkeiten, die Gestaltung dieser Angebote zu beeinflussen."

Was ChatGPT dazu sagt

Fragt man ChatGPT selbst, wie es gegen Geschlechterklischees anarbeitet, nennt es drei Maßnahmen: Erstens wird schon beim Training aufgeräumt – Inhalte mit sexistischen, rassistischen oder stereotypen Aussagen werden aus den Daten gefiltert. Zweitens lernt das Modell durch menschliches Feedback, welche Antworten fair und respektvoll sind. Und drittens wird es vor dem Release auf Stereotype getestet – etwa, ob es auf männliche und weibliche Namen unterschiedlich reagiert oder bestimmte Gruppen bevorzugt, die mit bestimmten Berufen oder Eigenschaften verbunden sind.

Doch auch mit größter Sorgfalt werden Stereotype bleiben. KI ist kein selbstlaufendes, neutrales System, sondern ein Spiegel gesellschaftlicher Strukturen. Wenn wir nicht gezielt gegensteuern, könnte sie bestehende Ungleichheiten weiter zementieren. Die Gewerkschaften sehen sich hier in der Verantwortung, die Interessen der Beschäftigten zu vertreten und auf eine faire Gestaltung von KI in der Arbeitswelt hinzuwirken. Denn eines ist klar: Eine gerechte Zukunft mit KI gibt es nur, wenn alle sie mitgestalten.

FAQ: Gendergerechtigkeit und KI

Was ist Gender Bias in Künstlicher Intelligenz?

Gender Bias bedeutet, dass KI-Systeme bestehende Geschlechterstereotype übernehmen und verstärken – etwa indem sie automatisch Ärzt*innen als männlich und Pflegekräfte als weiblich darstellen, auch wenn keine Geschlechtsangabe gemacht wurde.

Wie zeigt sich der Gender Gap bei der KI-Nutzung?

Studien zeigen: Frauen nutzen KI seltener, schätzen ihre Kompetenzen niedriger ein und vertrauen der Technologie weniger als Männer. Dieser Gender Gap besteht in allen Altersgruppen und kann bestehende Ungleichheiten in der Arbeitswelt verfestigen.

Was tun gegen Diskriminierung durch KI?

Expert*innen fordern mehr Transparenz, klare gesetzliche Standards (wie in der EU-KI-Verordnung) und institutionalisierte Diversity Panels zur Prüfung von Algorithmen. Auch Gewerkschaften spielen eine zentrale Rolle, etwa durch Betriebsvereinbarungen und gezielte Qualifizierungsangebote.

Welche Rolle spielt Mitbestimmung in Unternehmen?

Betriebs- und Personalräte können bei der Einführung von KI-Systemen mitwirken, Datenschutz- und Antidiskriminierungsstandards sichern und Räume für geschlechtersensible Weiterbildung schaffen – etwa reine Frauengruppen zur Förderung von digitaler Kompetenz.